当阿尔法狗击败围棋冠军李世石时,人们惊叹于人工智能的智慧;当ChatGPT写出流畅文章时,人们开始忧虑创造性工作的未来;当Deepfake技术生成真假难辨的视频时,一个根本性问题摆在我们面前:人工智能正在重新定义何为真实、何为道德、何为人类。

伦理争议的四个引爆点

- 偏见放大器:人工智能系统依赖训练数据,而数据往往反映着人类社会既有的偏见。美国某科技公司的人脸识别系统曾错误地将黑人识别为大猩猩;招聘算法被发现更倾向于选择男性简历。这些并非算法本身有偏见,而是它放大了我们社会中已存在的不平等。开发者面临拷问:我们是在建立更公平的世界,还是在用科技固化歧视?

- 隐私终结者:智能监控系统可以识别行人的每一步轨迹,语音助手可能在你不知情时记录对话,个性化推荐算法比你自己更了解你的喜好。当便利与隐私成为交换条件,我们该划清哪条界线?更令人不安的是,这些数据一旦被滥用,可能成为社会控制的工具。

- 责任真空区:自动驾驶汽车在不可避免的事故中该如何选择?是保护车内乘客还是路人?当医疗诊断AI出现误判导致患者死亡,责任在开发者、医院还是算法本身?现有的法律框架难以应对这些新问题,形成了伦理与责任的灰色地带。

- 人类性危机:当AI伴侣比真人更懂你的情绪,当虚拟偶像收获千万粉丝,当聊天机器人被用户表白,我们不得不思考:人际关系是否正在被重新定义?如果机器能完美模拟情感,真实的人类连接价值何在?

开发者站在十字路口

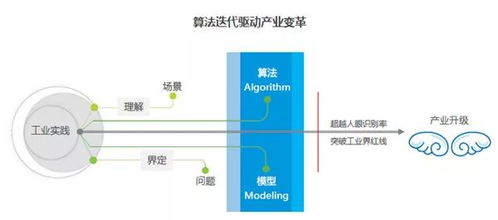

人工智能开发者不再是单纯的技术人员,他们实际上成为了隐形的伦理立法者。每一行代码、每一个算法选择都在塑造未来的社会形态。当前AI开发面临三重困境:

- 商业利益与伦理的冲突:快速上市的压力常使伦理考量被置于次要位置

- 技术复杂性与透明度的矛盾:深度学习如同‘黑箱’,连开发者都难以完全解释其决策过程

- 全球竞争与统一标准的落差:各国在AI伦理规范上步调不一,形成监管洼地

寻找第三条道路

面对这些挑战,负责任的AI开发需要多管齐下:

伦理前置设计必须成为行业标准。如同建筑需要安全规范,AI系统应在开发初期就嵌入伦理考量,建立‘伦理影响评估’机制。

跨学科协作至关重要。工程师需要与哲学家、社会学家、法律专家对话,建立多元视角。微软、谷歌等公司已设立AI伦理委员会,但这不应只是大公司的特权。

可解释AI(XAI)研发需加速推进。只有当算法决策过程变得透明,我们才能有效监督和问责。

公众参与不可或缺。AI将影响每个人,其发展方向不应仅由技术精英决定。通过公民论坛、伦理研讨会等形式,让社会共识引导技术发展。

在颠覆中重建

人工智能确实在颠覆我们的‘三观’——世界观、价值观、人生观。但每一次技术革命都伴随着伦理重构。印刷术挑战了知识垄断,工业革命重塑了劳动伦理,互联网改变了隐私观念。如今,我们站在新的历史节点,需要的不是抵制进步,而是在创新中注入更多人文关怀。

最深刻的问题或许不是‘人工智能能做什么’,而是‘我们应该用它来建设什么样的世界’。每一次敲击键盘,每一段编写代码,都是在回答这个问题的过程中,留下我们的选择印记。在这个算法日益渗透生活的时代,保持对人性的坚守,或许才是最颠覆性的‘技术创新’。